视频内容分析与理解方向

[1]. Ruize Han, Haomin Yan, Jiacheng Li, Wei Feng, Songmiao Wang, Song Wang. Panoramic Human Activity Recognition. ECCV, 2022.

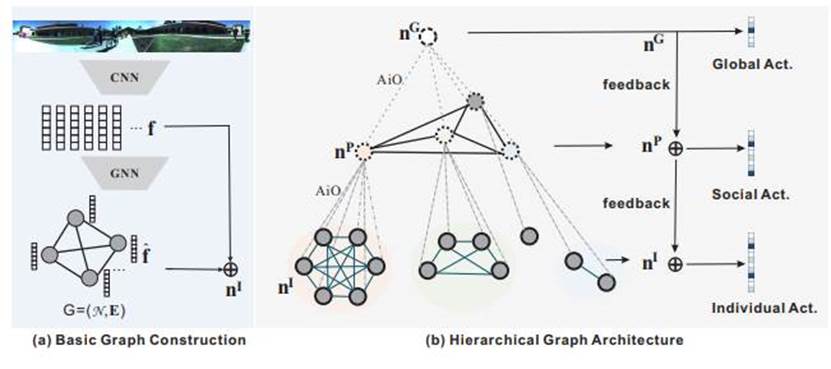

为全面理解拥挤场景中的人类活动,本文提出了全景人类活动识别(PAR)的新问题,旨在同时识别个体动作、社交群体活动和全局活动。这在现实世界应用中是一个极具挑战性的实用问题。为此,我们开发了一个新的层次图神经网络,以逐步表示和建模多粒度的人类活动和相互社交关系。

代码开源于:https://github.com/RuizeHan/PAR

图1:PAR框架图

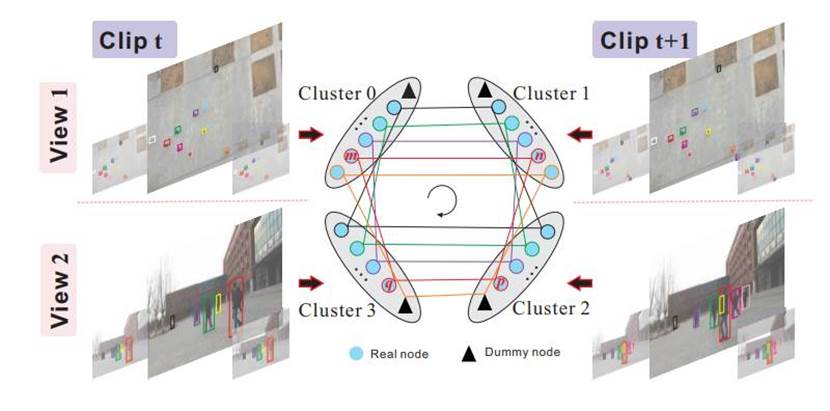

[2]. Ruize Han, Wei Feng, Feifan Wang, Zekun Qian, Haomin Yan, Song Wang. Benchmarking the Complementary-View Multi-human Association and Tracking. IJCV, 2023.

本文介绍了一个包含由无人机和可穿戴摄像头同步录制的视频的新数据集,其中包括对涉及主体及其跨帧和跨视图关联的高质量注释。同时提出了一个针对多视角多人跟踪的相关基准算法,并在该新数据集上与注释的地面真相进行评估。实验证明了新数据集的实用性和提出的基准算法的有效性。

代码开源于: https://github.com/RuizeHan/MHATB

图2:MHATB框架图

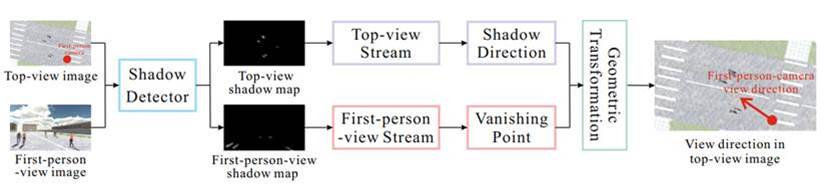

[3]. Ruize Han, Yiyang Gan, Likai Wang, Nan Li, Wei Feng, Song Wang. Relating View Directions of Complementary-View Mobile Cameras via the Human Shadow. IJCV, 2023.

本研究通过使用移动摄像头进一步探索了视频监控的潜力。高空无人机搭载的摄像头可以提供全局透视的顶视图,而地面上由人们佩戴的摄像头则可以提供更具局部细节的一人称视图。为了进行协同分析并关联这两种视图,我们提出在全局顶视图中定位一人称视图摄像头的视野。由于它们之间存在巨大的视角差异和不确定的摄像头运动,这是一个非常具有挑战性的问题。在这项工作中,我们探讨了使用太阳光方向作为关联这两种视图的桥梁。具体而言,我们设计了一个考虑阴影方向的网络,同时定位一人称视图中的阴影消失点和顶视图中的阴影方向。然后,我们应用多视图几何来估计一人称视图摄像头在顶视图中的偏航和俯仰角。我们构建了一个包含顶视图和一人称视图图像对的新合成数据集,用于性能评估。

代码开源于:https://github.com/RuizeHan/CVCR

图3:CVCR框架图

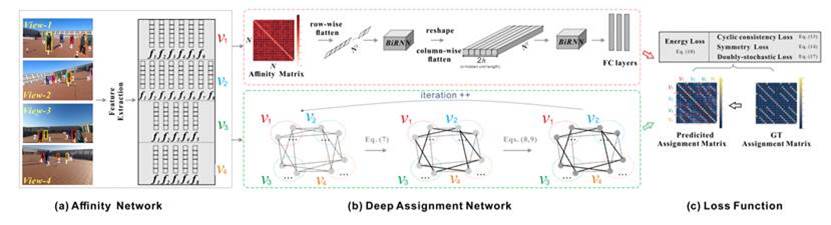

[4]. Ruize Han, Yun Wang, Haomin Yan, Wei Feng, Song Wang. Multi-view Multi-human Association with Deep Assignment Network. IEEE TIP, 2022.

本文研究了在同一时间由不同摄像头拍摄的多视图图像上的多视图多人关联(MvMHA)问题,即在多于两个视图的更一般和具有挑战性的情景中,其中这些视图均不是固定或先验已知的。每个涉及的人可能出现在所有视图或仅出现在其中一些视图中,这也是未先知的。我们提出了一个基于端到端深度网络的新框架来解决这个问题。首先,我们使用基于外观的深度网络提取每个图像上每个检测到主体的特征。然后,我们计算所有检测到的主体之间的成对相似度分数,并构建一个全面的关联矩阵。末尾,我们提出了一个深度分配网络(DAN)将关联矩阵转换为一个分配矩阵,为MvMHA提供二进制的关联结果。我们构建了一个合成数据集和一个真实图像数据集来验证所提方法的有效性。我们还在其他三个公共数据集上测试了训练过的网络,结果表现出很好的跨域性能。

代码开源于:https://github.com/RuizeHan/DAN4Ass

图4:DAN4Ass框架图

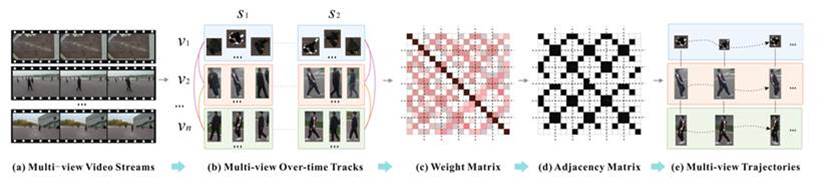

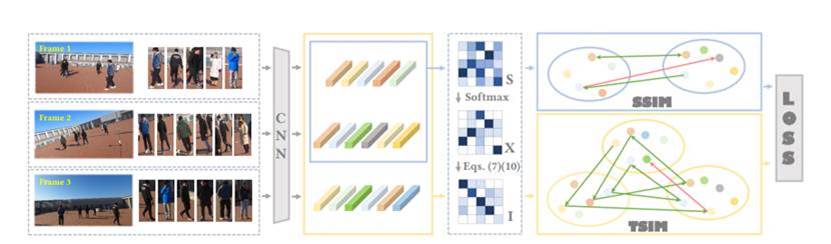

[5]. Yiyang Gan, Ruize Han, Liqiang Yin, Wei Feng, Song Wang. Self-supervised Multi-view Multi-Human Association and Tracking. In ACM MM, 2021.

该论文致力于解决多视图多人关联与追踪(MvMHAT)问题,旨在在每个视图中随时间追踪一组人,同时在同一时间跨不同视图识别同一人。虽然这是一个相对较新的问题,但在多人场景视频监控中具有重要意义。与先前的多目标跟踪(MOT)和多目标多摄像头跟踪(MTMCT)任务不同,这两者仅考虑随时间的人员关联,而MvMHAT需要同时实现跨视图和随时间的数据关联。在这篇论文中,我们使用自监督学习框架对该问题进行建模,并利用端到端网络来解决它。具体而言,我们提出了一个带有两个设计的自监督学习损失的时空关联网络,包括对称相似性损失和传递相似性损失,用于在每个时间点关联多个人员,实现跨视图和随时间的关联。

代码开源于:https://github.com/RuizeHan/MvMHAT

图5:MvMHAT框架图

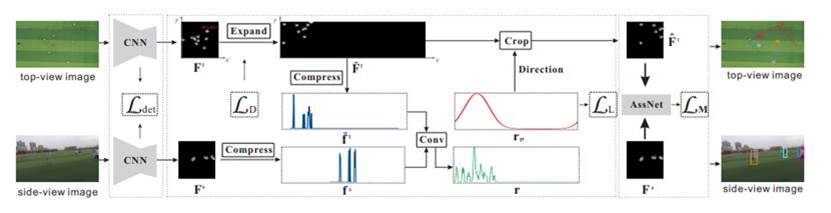

[6]. Ruize Han, Yiyang Gan, Jiacheng Li, Feifan Wang, Wei Feng, Song Wang. Connecting the Complementary-view Videos: Joint Camera Identification and Subject Association. In CVPR, 2022. (DMHA)

本文旨在连接来自互补视角的数据,即来自空中无人机摄像头的顶视图和地面可穿戴摄像头的侧视图。对这种互补视角数据的协同分析可以促进建立用于各种应用的空地协同视觉系统。由于顶视图和侧视图之间存在巨大的视角差异,这是一个非常具有挑战性的问题。在本文中,我们开发了一种新方法,可以同时处理三个任务:i)在顶视图中定位侧视摄像头;ii)估计侧视摄像头的视角方向;iii)在互补视角中检测和关联地面上相同的主体。我们的主要思想是探索两个视图中主体的空间位置布局。具体而言,我们提出了一种空间感知位置表示方法,用于嵌入不同视图中主体的空间位置分布。我们进一步设计了一个由摄像头识别模块和主体关联模块组成的跨视图视频协作框架,以同时执行上述三个任务。

代码开源于:https://github.com/RuizeHan/DMHA

图6:DMHA框架图

[7]. Ruize Han, Wei Feng, Jiewen Zhao, Zicheng Niu, Yujun Zhang, Liang Wan, Song Wang. Complementary-View Multiple Human Tracking. In AAAI, 2020.

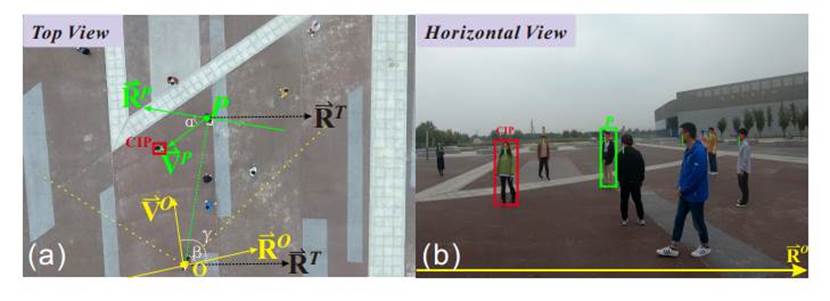

本文研究了从同一时间拍摄的一对顶视图和水平视图视频中进行多人跟踪的新问题。我们的目标是在两个视图中跟踪人类并逐帧识别两个互补视图中的同一人,由于视野差异非常大,这是一个非常具有挑战性的问题。在本文中,我们使用外观和运动推理来建模每个视图中的数据相似性,并使用外观和空间推理来建模视图之间的相似性。将它们结合起来,我们将所提出的多人跟踪问题制定为一个联合优化问题,可以通过受约束的整数规划来解决。

代码开源于:https://github.com/RuizeHan/CVMHT

图7:CVMHT框架图

[8]. Ruize Han, Jiewen Zhao, Wei Feng, Yiyang Gan, Liang Wan, Song Wang. Complementary-View Co-Interest Person Detection. In ACM MM, 2020.

迅速准确地识别共同兴趣的人,即吸引周围人共同关注的人,对于社交场景的理解和监控起着重要作用。先前的研究主要集中在从单一视图视频中检测共同兴趣的人。在本文中,我们研究了一个更为现实和具有挑战性的问题,即从多个时间同步的视频中检测共同兴趣人(CIP)。具体而言,我们使用一个安装在高空飞行的无人机上的顶视摄像头,以获取整个场景和地面上所有主体的全局视图,以及由选定的主体佩戴的多个水平视摄像头,以获取他们附近人员和环境细节的局部视图。我们提出了一种高效的顶视和水平视数据融合策略,将多个水平视图映射到全局顶视图中。然后,我们提出了一个空间-时间CIP潜在能量函数,共同考虑了帧内置信度和帧间一致性,从而导致了一个有效的条件随机场(CRF)公式。

代码开源于:https://github.com/RuizeHan/CIP

图8:CIP框架图

[9]. Qing Guo, Ruize Han, Wei Feng, Zhihao Chen, Liang Wan. Selective Spatial Regularization by Reinforcement Learned Decision Making for Object Tracking. IEEE TIP, 2017.

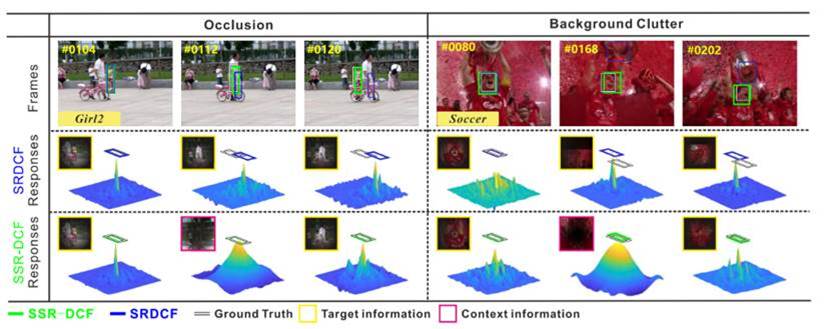

本文提出了一种选择性空间正则化(SSR)的相关滤波(CF)跟踪方案,以解决空间正则化在提高视觉对象跟踪准确性的同时,增加了优化复杂性和易于失去被其他相似对象遮挡的目标等问题。与简单依赖前景信息不同,我们将CF跟踪方案的目标函数扩展到使用目标上下文驱动的权重图来学习目标上下文正则化的滤波器。我们将这些权重图的在线选择建模为一个马尔可夫决策过程(MDP)的决策问题,其中权重图选择的学习等同于MDP的策略学习,通过强化学习策略进行求解。此外,通过在MDP中添加一个表示不更新滤波器的特殊状态,我们可以学习何时跳过不必要或错误的滤波器更新,从而加速在线跟踪。最后,提出的SSR被用于加强三种流行的空间正则化CF跟踪器,显著提高它们的跟踪准确性,并实现更快的在线跟踪速度。

代码开源于:https://github.com/RuizeHan/SSR-CF

图9:SSR-CF框架图

[10]. Wei Feng, Ruize Han, Qing Guo, Jianke Zhu, Song Wang. Dynamic Saliency-aware Regularization for Correlation Filters based Object Tracking. IEEE TIP, 2019.

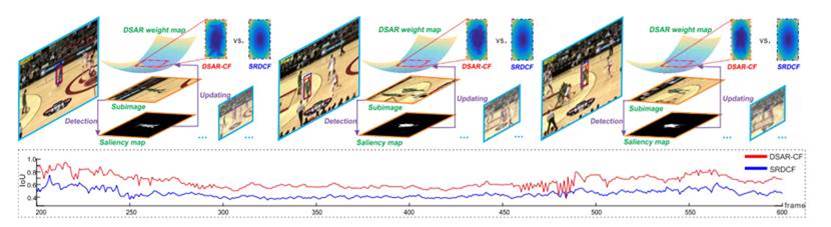

具有良好的跟踪准确性和速度平衡的相关滤波(CF)已经成为对象跟踪框架之一,基于此框架开发了许多成功的跟踪器。近来,为了纠正CF跟踪的边界效应,进一步提升跟踪性能,发展了空间正则化的CF跟踪(SRDCF)。然而,SRDCF使用从宽松边界框构建的固定空间正则化映射,当目标或背景显示显著变化时(如目标变形或遮挡),其性能不可避免地降级。为解决这个问题,我们提出了一种新的动态显著性感知正则化的CF跟踪(DSAR-CF)方案。在DSAR-CF中,定义了一个简单而有效的能量函数,反映了时空域内的对象显著性和跟踪可靠性,以引导使用高效的水平集算法在线更新正则化权重图。

代码开源于:https://github.com/RuizeHan/DSAR-CF

图10:DSAR-CF框架图

多模态理解与应用方向

[1]. Lianyu Hu, Liqing Gao, Zekang Liu, Chi-Man Pun, Wei Feng. COMMA: Co-Articulated Multi-Modal Learning[C]. AAAI2024.

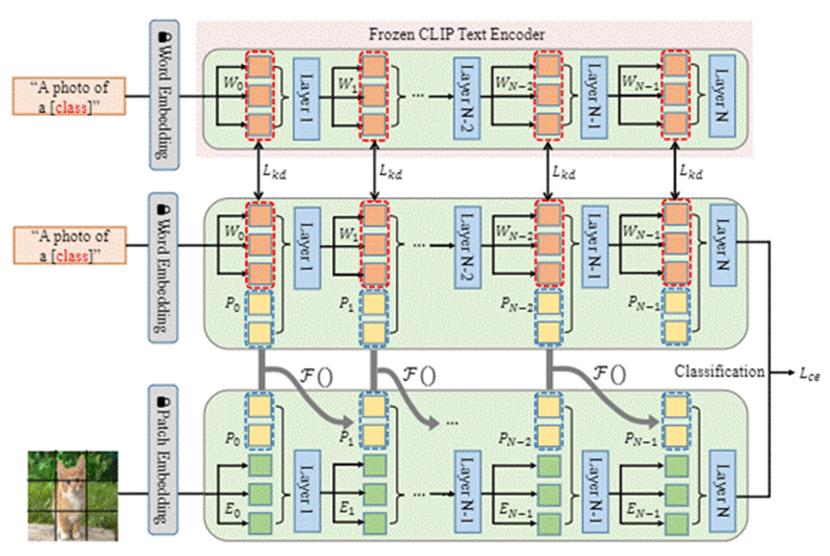

本文针对当前高效参数微调方法忽略不同模态之间的提示互补性的问题,提出构建不同模态间提示的关联,并从预训练大模型中补充高泛化性的知识,在多个数据集上达到SOTA精度。

代码开源于https://github.com/hulianyuyy/COMMA

图1:COMMA框架图

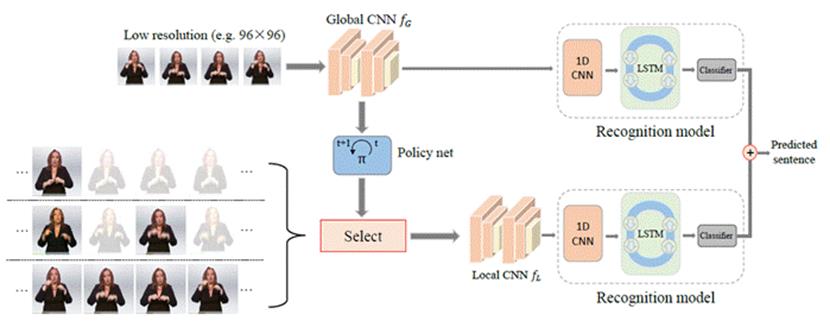

[2]. Lianyu Hu, Liqing Gao, Zekang Liu, Chi-Man Pun, Wei Feng. AdaBrowse: Adaptive Video Browser for Efficient Continuous Sign Language Recognition[C]//Proceedings of the 31st ACM International Conference on Multimedia. 2023: 709-718.

本文针对当前手语方法消耗计算量大的问题,提出动态切换每个视频的序列长度和空间分辨率,在多个数据集上大大降低了计算量且维持识别精度。

代码开源于https://github.com/hulianyuyy/AdaBrowse

图2:AdaBrowse框架图

[3]. Lianyu Hu, Liqing Gao, Zekang Liu, Wei Feng. Continuous Sign Language Recognition with Correlation Network[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2023: 2529-2539.

本文针对当前手语方法独立处理视频各帧,而忽略了帧间关联的问题,提出显性捕捉帧之间的运动轨迹,在多个数据集上实现SOTA精度。

代码开源于https://github.com/hulianyuyy/CorrNet

图3:CorrNet框架图

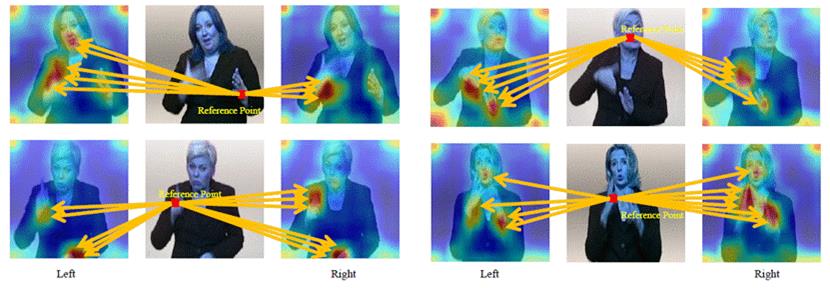

[4]. Lianyu Hu, Liqing Gao, Zekang Liu, Wei Feng. Self-emphasizing network for continuous sign language recognition[C]//Proceedings of the AAAI Conference on Artificial Intelligence. 2023, 37(1): 854-862.

手语主要由人体脸部和手部表达,然而当前方法难于显性的利用这些特征。本文提出以低计算量的形式,强调关键的时间和空间区域,在多个数据集上实现SOTA精度。

代码开源于https://github.com/hulianyuyy/SEN_CSLR

图4:SEN框架图

[5]. Lianyu Hu, Liqing Gao, Zekang Liu, Wei Feng. Temporal lift pooling for continuous sign language recognition [C]//ECCV2022.

当前方法通常使用max池化或平均池化来提取时间特征,然而这两种方法未必是较好的。本文提出一种新的基于提升思想的池化方法,在多个数据集上实现SOTA精度。

代码开源于https://github.com/hulianyuyy/Temporal-Lift-Pooling

图5:TLP框架图

微变视觉与数字文化遗产方向

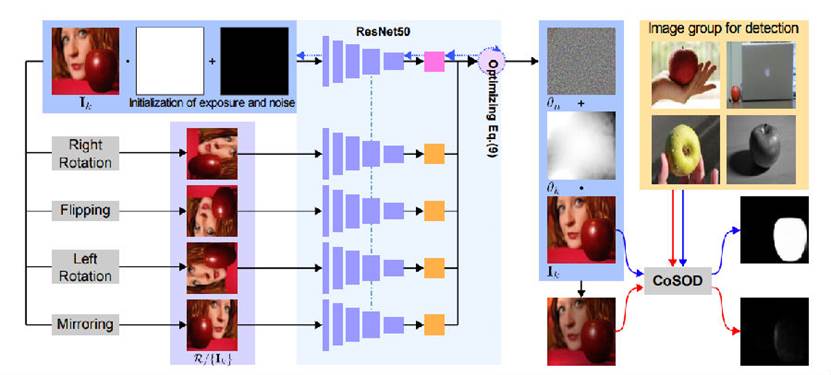

[1].Ruijun Gao, Qing Guo, Felix Juefei-Xu, Hongkai Yu, Huazhu Fu, Wei Feng, Yang Liu, Song Wang. Can You Spot the Chameleon? Adversarially Camouflaging Images from Co-Salient Object Detection. CVPR, 2022. CCF-A类会议论

提出了第 一个黑箱联合对抗曝光和噪声攻击(Jadena),其中根据新设计的高特征级对比度敏感损失函数共同局部调整图像的曝光和加性扰动。我们的方法在没有任何关于先进的共同显著性检测方法的信息的情况下,在各种共同显著性检测数据集上表现出显著的性能下降,并使共显著对象难以检测。对于正确保护目前在互联网上共享的大量个人照片具有强大的实际好处。

代码开源于https://github.com/tsingqguo/jadena.

图1:jadena框架图

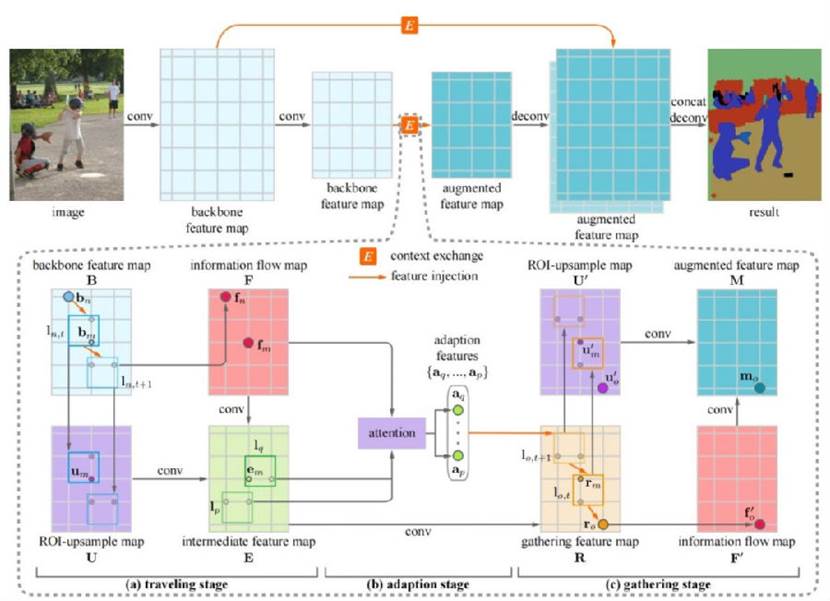

[2].Di Lin, Dingguo Shen, Yuanfeng Ji, Siting Shen, Mingrui Xie, Wei Feng, Hui Huang. TAGNet-Learning Configurable Context Pathways for Semantic Segmentation. TPAMI, 2022, 45(2): 2475-2491.

以图的角度针对现有上下文模型进行比较,针对目前先进的上下文传播方式采用的空间金字塔池化容易丢失底层的细节信息以及上下文增强中先进的的图模型方式需要预训练好的路径,缺少灵活性的问题,提出一种基于可配置上下文路径的图像语义分割方法(Travel-Adapt-Gather network, TAGNet),来增加图像上下文信息聚合灵活度和提高语义分割精度。

代码开源于https://github.com/dilincv/TAGNet

图2:TAGNet框架图

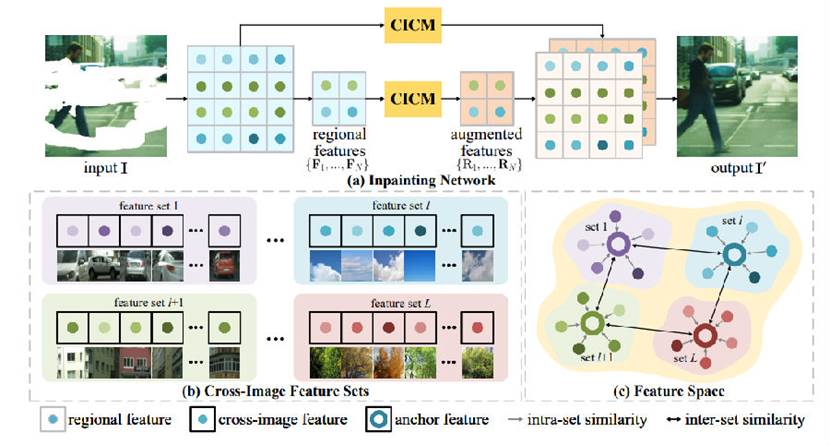

[3].Tingliang Feng, Wei Feng, Weiqi Li, Di Lin. Cross-Image Context for Single Image Inpainting. NeurlPS, 2022.

提出了交叉图像上下文记忆(CICM),用于学习和利用跨图像上下文来恢复受损区域。CICM由从具有不同视觉模式的图像区域学到的多组交叉图像特征组成。这些区域特征跨越不同图像学习,因此提供了有益于修复任务的更丰富上下文。实验证明了CICM的有效性和泛化能力,在各种数据集上实现了单图像修复的SOTA性能。

代码开源于https://github.com/fengtl/CICM

图3:CICM框架图

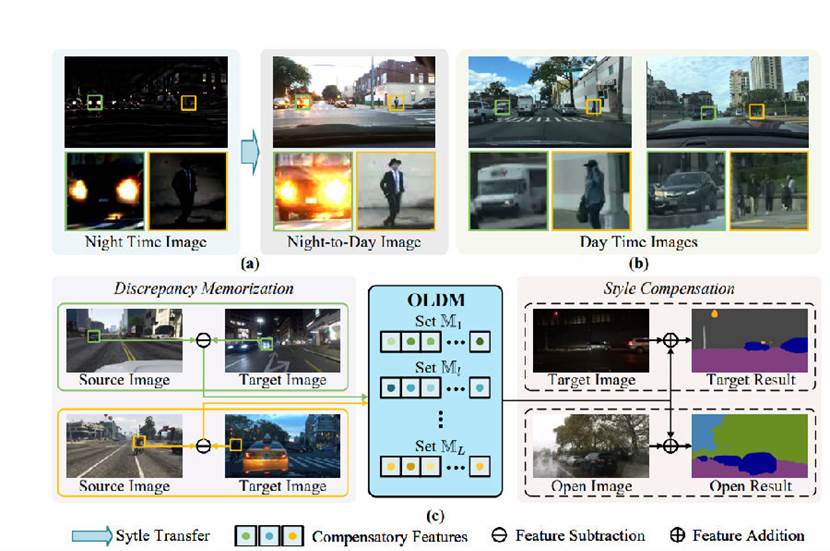

[4].Tingliang Feng, et al. Open Compound Domain Adaptation with Object Style Compensation for Semantic Segmentation. NeurlPS, 2023.

本文提出了对象样式补偿。我们从源域和目标域的图像中学习差异特征,并将其存储在内存中。通过这个存储器,我们选择适当的差异特征来补偿各种类别对象实例的样式信息,将对象样式调整为源域的统一样式。我们的方法能够更准确地计算目标域图像的伪标注,从而在不同数据集上实现SOTA的结果。

代码开源于https://github.com/fengtl/OLDM.

图4:Style Compensation框架图

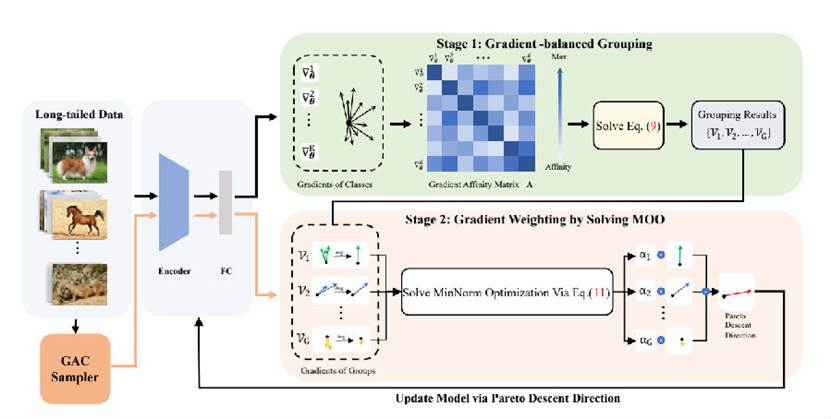

[5].Weiqi Li, Fan Lyu, Fanhua Shang, Liang Wan, Wei Feng. Long-Tailed Learning as Multi-Objective Optimization. AAAI,2024.

在本文中我们将长尾识别构建为一个多目标优化问题,同时公平地尊重头部和尾部类别的贡献。为了提高效率,提出了一个梯度平衡分组(GBG)策略,将具有相似梯度方向的类别聚集在一起,从而近似使每次更新都在Pareto下降方向上进行。我们在长尾学习中常用的基准数据集上进行了大量实验证明我们的方法在性能上优于现有的先进方法。

代码开源于https://github.com/WickyLee1998/GBG_v1.

图5:GBG框架图

医学影像处理与理解方向

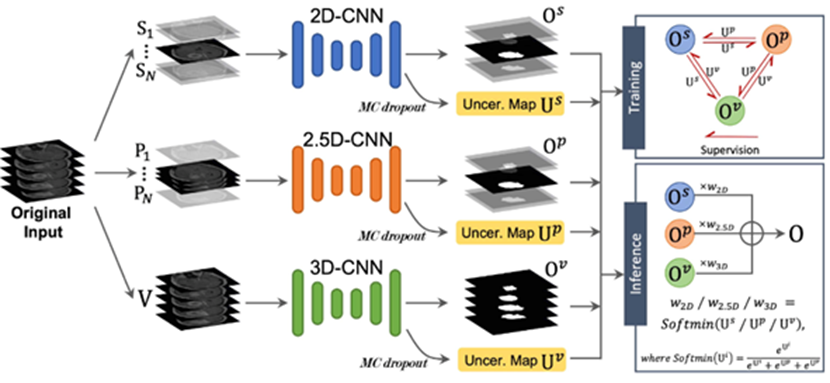

[1] Junting Zhao, Zhaohu Xing, Zhihao Chen, Liang Wan, Tong Han, Huazhu Fu, and Lei Zhu. Uncertainty-aware Multi-dimensional Mutual Learning for Brain and Brain Tumor Segmentation. IEEE Journal of Biomedical and Health Informatics, 2023.

针对脑膜瘤分割工作中,存在融合跨模态信息时忽略模态差异性且容易引入模态间噪声信息的问题,提出了基于冗余信息过滤的跨模态互学习脑膜瘤分割框架。

代码开源于https://github.com/CindyZJT/UMM-Net.git。

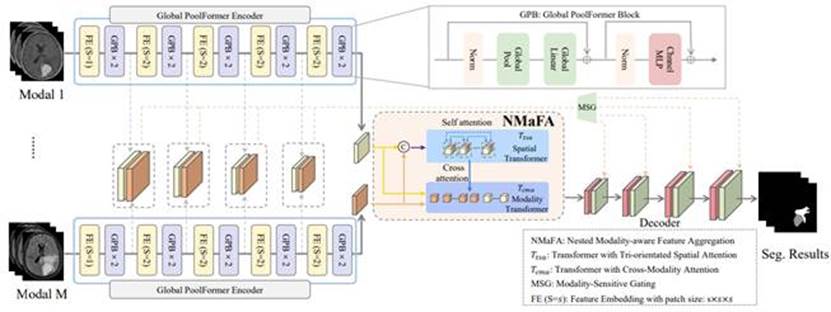

[2] Xing, Z., Yu, L., Wan, L., Han, T., Zhu, L. NestedFormer: Nested Modality-Aware Transformer for Brain Tumor Segmentation. MICCAI 2022.

本文针对当前多模态MRIs分割方法无法捕捉多模态之间复杂的非线性关系的问题,提出基于注意力的多模态融合算法,深度捕捉模态内及模态间的相互关系,实现对脑膜瘤MRI的肿瘤与水肿区域的分割。

代码开源于https://github.com/920232796/NestedFormer。

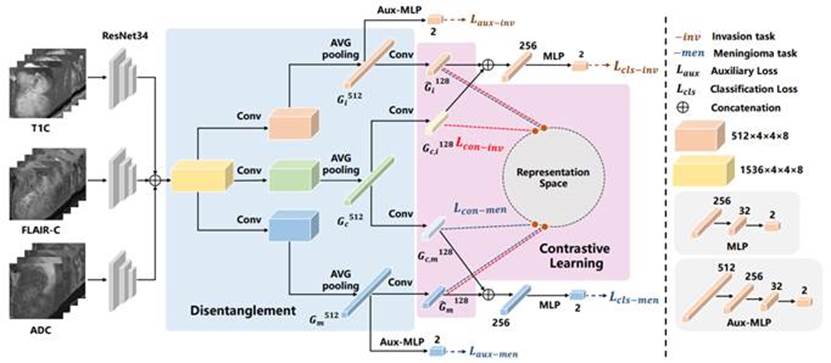

[3] Liu, T., Liu, W., Yu, L., Wan, L., Han, T., Zhu, L. Joint Prediction of Meningioma Grade and Brain Invasion via Task-Aware Contrastive Learning. MICCAI 2022.

本文针对当前脑膜瘤预测方法无法实现对脑膜瘤分级以及脑侵袭分类两个任务的预测的缺点,基于多模态MRIs,提出任务级特征解耦方法以及任务级对比学习方法,深入发掘多模态MRIs中不同任务的相关信息,同时完成对两个任务的准确预测。

代码开源于https://github.com/IsDling/predictTCL。

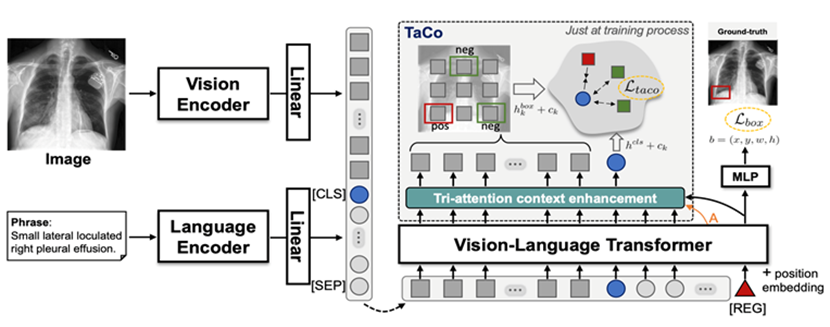

[4] Zhihao Chen, Yang Zhou, Anh Tran, Junting Zhao, Liang Wan et al. Medical phrase grounding with region-phrase context contrastive alignment[C]. International Conference on Medical Image Computing and Computer-Assisted Intervention 2023.

针对现有医学短语定位方法依赖于普通视觉特征来识别自然图像中的对象,无法捕捉医学发现的微妙和专门特征,从而导致性能不佳的问题,提出了一种端到端的MPG方法MedRPG,MedRPG基于轻量级的视觉-语言变换器编码器,并直接预测所述医学发现的框坐标。

代码开源于https://github.com/eraserNut/MedRPG。

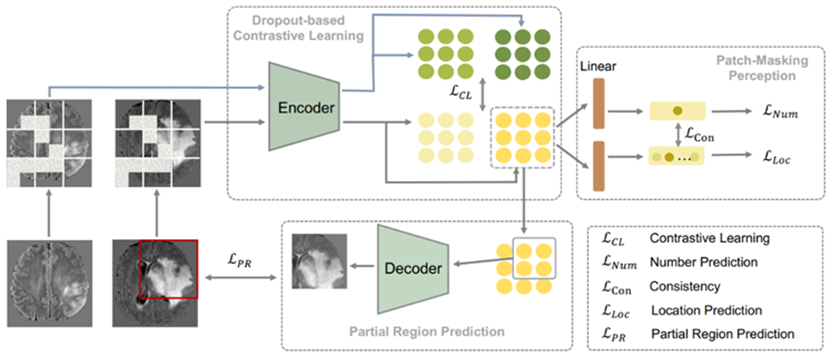

[5] Xing Z, Zhu L, Yu L, et al. Hybrid Masked Image Modeling for 3D Medical Image Segmentation[J]. IEEE Journal of Biomedical and Health Informatics, 2024.

针对医学图像领域中高质量的标注数据难以获取的问题,本文提出了一种新颖的基于遮蔽图像建模的混合自监督学习的预训练模型,可以在大量未标注或自动标注的数据上进行训练,减轻标注数据不足的问题。

代码开源于https://github.com/ge-xing/HybridMIM。